Podsumowanie artykułu

- CI/CD automatyzuje proces wytwarzania i wdrażania aplikacji, skracając time-to-market.

- Continuous Integration eliminuje integration hell dzięki częstym commitom i automatyzacji testów.

- Continuous Delivery gwarantuje gotowość zmian do wdrożenia na produkcję „jednym kliknięciem”.

- Continuous Deployment usuwa ręczne kroki i umożliwia automatyczne publikacje nowych wersji.

- Pipeline CI/CD obejmuje build, testy, analizy jakości, staging i wdrożenie na produkcję.

- Automatyzacja zmniejsza koszty operacyjne i pozwala na częstsze dostarczanie sprawdzonych zmian w kodzie aplikacji.

- Agenci AI w pipeline’ach diagnozują błędy, przewidują awarie i wykonują rollbacki.

- AIOps to obiecujący trend, ale wymaga nadzoru człowieka, explainability i modelu zero-trust.

CI/CD (Continuous Integration/Continuous Delivery/Continuous Deployment) to praktyka inżynierska, która koncentruje się na pełnej automatyzacji procesu wytwarzania i wdrażania aplikacji. Obejmuje ona wszystkie etapy cyklu życia oprogramowania: od testowania jednostkowego i integracyjnego, przez budowanie artefaktów, aż po publikację wersji produkcyjnych. Jej celem jest eliminacja manualnych działań związanych z monitorowaniem, dostarczaniem i wdrażaniem kodu, co przekłada się na krótszy time-to-market, większą stabilność i mniejszą podatność na błędy ludzkie.

CI/CD to obecnie standard w dojrzałych procesach developerskich. Podejście oparte na automatyzacji przynosi wymierne korzyści zarówno programistom, jak i firmom. Dla zespołów developerskich oznacza to szybszy feedback, mniej pracy manualnej oraz stabilne środowisko pracy. z kolei dla firm wdrożenie CI/CD to przewidywalne procesy wdrożeniowe, wyższa jakość produktu i redukcja kosztów operacyjnych. Dzięki temu całe organizacje mogą rozwijać oprogramowanie w sposób bardziej efektywny, bezpieczny i skalowalny.

Continuous Integration (CI) — ciągła integracja

Continuous Integration to proces regularnego integrowania zmian kodu w repozytorium głównym (np. main/develop). Dzięki temu zespół, w którym wielu programistów pracuje równolegle, unika kosztownych konfliktów i tzw. integration hell.

W praktyce CI oznacza, że każdy commit uruchamia pipeline automatyczny, który:

- buduje aplikację,

- uruchamia testy jednostkowe i integracyjne,

- wykonuje dodatkowe kroki, takie jak statyczna analiza kodu (lint, security scan, code coverage).

Częste integrowanie zmian pozwala szybko wykrywać problemy i natychmiast je usuwać. To kluczowe, ponieważ:

- testy jednostkowe weryfikują poprawność logiki poszczególnych komponentów,

- testy integracyjne sprawdzają współpracę między modułami (np. API i bazą danych).

Dzięki automatyzacji CI zespoły nie muszą ręcznie uruchamiać testów ani przeprowadzać scalania kodu. Narzędzia takie jak Jenkins, GitLab CI, GitHub Actions czy CircleCI wykonują te zadania automatycznie. Efekt?

- szybkie wykrywanie i usuwanie błędów,

- mniejsze koszty utrzymania,

- znacząco wyższa jakość kodu jeszcze przed wydaniem aplikacji użytkownikom.

Continuous Delivery (CD) — ciągłe dostarczanie

Continuous Delivery to kolejny etap procesu. Jego celem jest zagwarantowanie, że każda zmiana, która przeszła przez CI, jest gotowa do wdrożenia na produkcję. w praktyce oznacza to, że pipeline:

- buduje artefakty (np. obrazy Dockera, paczki JAR/WAR, biblioteki NPM),

- publikuje je do repozytoriów (np. GitHub Packages, Nexus, Artifactory),

- wdraża aplikację na środowiska testowe lub stagingowe.

Tak przygotowany kod może być w dowolnym momencie wdrożony na produkcję „jednym kliknięciem”. Dzięki temu zespoły operacyjne otrzymują stabilne i przewidywalne wydania, a firmy mogą szybciej reagować na potrzeby rynku.

Continuous Deployment — ciągłe wdrażanie

Continuous Deployment idzie o krok dalej niż Delivery, automatyzując także ostatni etap — publikację aplikacji na produkcji. Każda zmiana, która przejdzie testy i walidacje, jest automatycznie wdrażana na środowisko produkcyjne.

Takie podejście ma następujące zalety:

- użytkownicy natychmiast otrzymują nowe funkcje i poprawki,

- wdrożenia stają się powtarzalne i przewidywalne,

- firmy mogą wdrażać nawet kilka wersji dziennie, reagując na feedback klientów,

- w razie problemów system umożliwia szybki rollback do poprzedniej stabilnej wersji.

Continuous Deployment to rozwiązanie dla organizacji, które stawiają na szybkie iteracje i maksymalną automatyzację, bez konieczności manualnej ingerencji w proces wdrożenia.

Różnica między Continuous Delivery a Continuous Deployment

Rozróżnienie pomiędzy Continuous Delivery (CD) a Continuous Deployment (CD) nie sprowadza się wyłącznie do uniknięcia niezgrabnego skrótu „CI/CD/CD”. Oba procesy są oparte na tym samym fundamencie, stabilnym systemie automatycznych testów w ramach Continuous Integration, ale różnią się poziomem automatyzacji w momencie publikacji aplikacji.

- Continuous Delivery zakłada, że każda zmiana, która przeszła proces CI, jest gotowa do wdrożenia na produkcję, ale sama decyzja o publikacji należy do zespołu. Kod jest w pełni przetestowany i dostępny w repozytorium artefaktów (np. obraz Docker, paczka Helm), lecz jego publikacja wymaga ręcznego zatwierdzenia.

- Continuous Deployment usuwa ten krok — pipeline automatycznie wdraża każdą zweryfikowaną zmianę na środowisko produkcyjne bez ingerencji człowieka.

Wybór między Delivery a Deployment zależy od procedur przyjętych w organizacji. Zespoły, które chcą zachować dodatkową kontrolę biznesową lub prawną nad wdrożeniami, często zatrzymują się na etapie Continuous Delivery. z kolei firmy stawiające na szybkie iteracje i częste wydania (np. SaaS) preferują pełne Continuous Deployment.

Ostateczną strategię ustala zespół projektowy wraz z klientem, dobierając poziom automatyzacji do wymagań biznesowych i ryzyka operacyjnego.

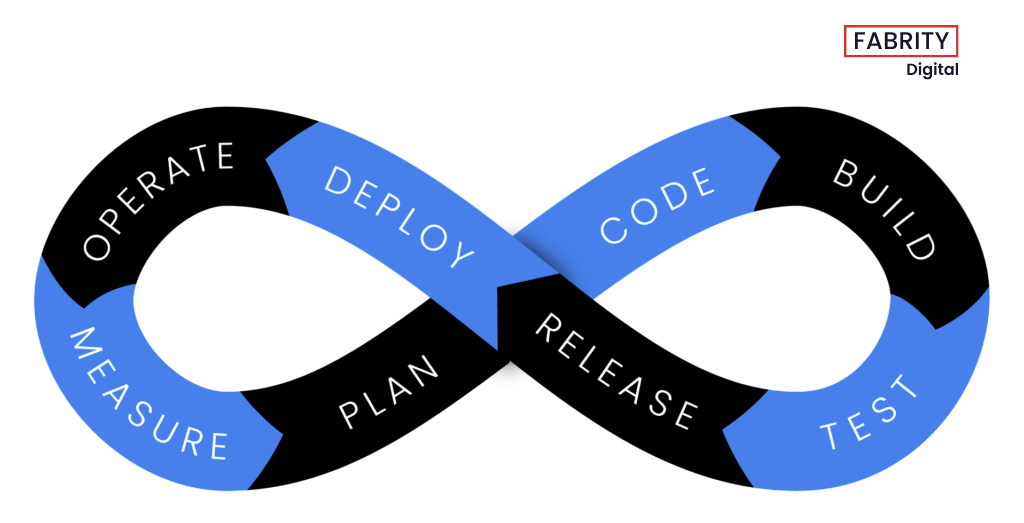

Pipeline CI/CD — fundament automatyzacji

Połączenie etapów CI, CD (Delivery) i opcjonalnie CD (Deployment) tworzy spójny przepływ pracy — pipeline CI/CD. Pipeline to nic innego jak sekwencja automatycznych kroków, które każda zmiana w kodzie musi przejść, aby trafić na produkcję.

Typowy pipeline CI/CD obejmuje:

- Commit i build — kod trafia do repozytorium, a pipeline uruchamia proces budowania aplikacji i generowania artefaktów.

- Testy automatyczne — jednostkowe, integracyjne, kontraktowe czy e2e, zapewniające, że aplikacja spełnia założone wymagania jakościowe.

- Analizy statyczne i bezpieczeństwa — np. linting, SAST, analiza pokrycia testami, skanowanie podatności w bibliotekach.

- Deployment na środowiska pośrednie — testowe, stagingowe, UAT, gdzie można zweryfikować wydajność i stabilność.

- Delivery / Deployment — dostarczenie aplikacji do repozytorium i/lub automatyczne wdrożenie na produkcję.

Dzięki pipeline’om CI/CD zespoły mogą:

- wdrażać zmiany często i bezpiecznie,

- reagować szybko na feedback użytkowników,

- minimalizować ryzyko błędów poprzez standaryzację procesu.

Pipeline nie jest tylko „narzędziem technicznym”. To infrastruktura procesu developerskiego, która decyduje o jakości, bezpieczeństwie i szybkości dostarczania wartości biznesowej.

Kryteria i optymalizacja pipeline’u CI/CD

Aby pipeline CI/CD działał optymalnie, każdy jego etap powinien mieć jasno zdefiniowane kryteria sukcesu. To one decydują, czy dany krok został wykonany poprawnie i czy zmiana może przejść dalej. Najczęściej są to:

- status testów automatycznych,

- wyniki analiz statycznych (lint, SAST, code coverage),

- spełnienie warunków jakościowych (np. brak regresji wydajnościowej).

Tak zdefiniowane kryteria pełnią funkcję bramek kontrolnych (quality gates) i stają się kluczowymi wskaźnikami efektywności (KPI) całego procesu. Menedżerowie mogą na ich podstawie monitorować postępy, a developerzy wiedzą dokładnie, jakie warunki muszą zostać spełnione, by kod trafił do następnego etapu.

Dzięki temu członkowie zespołu mogą równolegle realizować zadania o większej wartości — tworzyć nowe funkcje, naprawiać błędy, optymalizować infrastrukturę — mając pewność, że pipeline dba o ciągłość procesu i jakość wdrożeń.

Elastyczność procesu

Pipeline CI/CD jest elastyczny i skalowalny. w zależności od dojrzałości organizacji można wdrożyć tylko CI (ciągłą integrację), traktując ją jako fundament pod rozwój w modelu test-driven development.

W bardziej złożonych przypadkach proces obejmuje zarówno delivery, jak i deployment, co pozwala automatyzować cały cykl publikacji. Należy jednak pamiętać, że skuteczność CD zawsze opiera się na rzetelnie zrealizowanym etapie CI. Bez stabilnych buildów i testów automatycznych jakość wdrożeń byłaby wątpliwa, a ryzyko awarii wzrosłoby drastycznie.

Planowanie pipeline’u to nie tylko dobór etapów CI/CD, lecz także projektowanie workflow developerskich zgodnych z najlepszymi praktykami branżowymi. Wdrażanie standardów (code review, peer programming, trunk-based development) w połączeniu z pipeline’ami CI/CD wpływa pozytywnie na kulturę pracy zespołu, zwiększa produktywność i poprawia jakość końcowego produktu.

Najpopularniejsze narzędzia CI/CD

Budowa pipeline’u CI/CD nie musi oznaczać ogromnych kosztów początkowych. Wiele dojrzałych narzędzi oferuje gotowe rozwiązania oraz bogaty ekosystem wtyczek i integracji:

- Jenkins — najpopularniejszy serwer automatyzacji, obsługujący pełny zakres procesów CI i CD. Posiada ogromny ekosystem pluginów i sprawdza się w złożonych środowiskach enterprise.

- Jenkins X — wariant Jenkinsa zaprojektowany pod natywną integrację z Kubernetesem, ułatwiający budowę cloud-native pipeline’ów.

- AWS CodePipeline — usługa w chmurze Amazon Web Services, skupiona na automatyzacji continuous delivery. Łatwo integruje się z GitHubem i innymi repozytoriami.

- Concourse — open-source’owe narzędzie do CI/CD z wizualnym interfejsem przedstawiającym pipeline’y i punkty potencjalnych awarii.

- GitHub Actions — natywne rozwiązanie CI/CD w ekosystemie GitHub, wspierające dowolne języki programowania i integracje zewnętrzne.

- Azure Pipelines — element Azure DevOps, umożliwiający wdrażanie i testowanie aplikacji w modelu chmurowym z użyciem wspólnej infrastruktury zespołu.

- Spinnaker — platforma open-source wspierająca continuous delivery i multi-cloud deployment. Umożliwia m.in. automatyczne testy i roll-out na różnych platformach (Windows, macOS, Linux).

- Tekton — nowoczesny projekt open-source rozwijany w ramach CNCF, oferujący modularne podejście do budowy pipeline’ów CI/CD, łatwo integrujący się z Kubernetesem.

Korzyści biznesowe płynące z CI/CD

Oprócz oszczędności czasu i redukcji błędów, CI/CD daje organizacjom realne przewagi konkurencyjne:

- Satysfakcja użytkowników — krótszy cykl wydawniczy oznacza szybkie dostarczanie nowych funkcji i błyskawiczną reakcję na feedback użytkowników końcowych.

- Automatyzacja powtarzalnych zadań — mniej manualnych czynności, więcej przestrzeni na rozwój innowacyjnych funkcji.

- Szybsze usuwanie błędów — pipeline minimalizuje obciążenie poznawcze, a zespoły mogą reagować w momencie wystąpienia problemu.

- Wyższa jakość kodu — automatyczne testy i analizy statyczne gwarantują, że tylko sprawdzony kod trafia do repozytorium i środowisk produkcyjnych.

- Łatwe cofanie zmian (rollback) — repozytorium kodu i automatyzacja wdrożeń umożliwiają szybki powrót do poprzedniej wersji w razie krytycznej awarii.

CI/CD w 2025 — AIOps i agenci AI w pipeline’ach

CI/CD jest również obszarem, której nie ominęła rewolucja związana z generatywną sztuczną inteligencją. Mówi się obecnie nawet o AIOps (Artificial Intelligence for IT Operations), ponieważ dzięki wykorzystaniu AI pipeline’y stają się nie tylko automatyczne, ale także inteligentne i zdolne do samodzielnego reagowania na problemy.

Tradycyjnie zadaniem pipeline’u było budowanie aplikacji, uruchamianie testów i wdrażanie kodu na środowiska docelowe. w praktyce jednak wiele procesów wymagało manualnej interwencji — np. przy wykrywaniu błędów w konfiguracji, awariach buildów czy niespójnościach w środowisku. Dziś rolę tę przejmują agenci AI, którzy w czasie rzeczywistym analizują logi, metryki i alerty, a następnie podejmują działania naprawcze bez udziału człowieka.

Agenci AI potrafią m.in.:

- samodzielnie diagnozować i poprawiać błędy w konfiguracji pipeline’u,

- automatycznie generować brakujące testy lub modyfikować istniejące, gdy pokrycie nie spełnia kryteriów jakościowych,

- przewidywać potencjalne awarie na podstawie wcześniejszych danych, minimalizując ryzyko zatrzymania procesu,

- wykonywać rollbacki i restartować pipeline w najbardziej optymalny sposób, ograniczając straty czasowe.

Dzięki temu zespoły developerskie mogą skupić się na tworzeniu nowych funkcji, a nie na żmudnym utrzymaniu narzędzi. Co więcej, w wielu organizacjach agenci AI pełnią rolę „wirtualnych współpracowników” — komentują pull requesty, sugerują poprawki w kodzie czy proponują optymalizacje architektury aplikacji.

Nie oznacza to jednak, że AI zastępuje programistów i inżynierów DevOps. To wciąż nowa technologia, która wymaga świadomego nadzoru i odpowiednich środków ostrożności. Kluczowe stają się trzy obszary. Po pierwsze, zaufanie i audytowalność decyzji AI. Każda akcja agenta powinna być przejrzysta i możliwa do odtworzenia, aby zespoły wiedziały, dlaczego pipeline podjął określone działania. Po drugie, kontrola w postaci policy-as-code i approval gates, które pozwalają jasno zdefiniować reguły bezpieczeństwa i jakości oraz zatrzymać proces w krytycznych momentach, zachowując ludzką decyzję w najważniejszych etapach. Po trzecie, bezpieczeństwo oparte na modelu zero-trust, gdzie żadna akcja nie jest traktowana jako zaufana z góry, a każdy element pipeline’u działa w izolacji i z minimalnymi uprawnieniami. Dzięki temu AI agenci stają się nie tyle „autonomicznymi operatorami”, ile inteligentnymi asystentami wspierającymi zespoły, odciążając ich z powtarzalnych zadań, a jednocześnie pozostając pod pełną kontrolą organizacji.

Podsumowanie

Dzięki CI/CD zespoły unikają tzw. piekła integracji (ang. integration hell), a automatyzacja testów sprawia, że każda zmiana w kodzie przechodzi przez zestaw automatycznych walidacji, co zapewnia stabilność produktu i przewidywalność wdrożeń, a także pozwala na częstsze dostarczanie sprawdzonych zmian w kodzie aplikacji i utrzymanie wysokiej jakości kodu. Automatyzacja pipeline’u skraca proces wdrażania nowych funkcjonalności i dostarczania wartości biznesowej, zmniejsza koszty operacyjne i zwiększa elastyczność organizacji. Nic dziwnego, że CI/CD jest dziś uznawane za podstawę efektywnego procesu tworzenia oprogramowania.

Coraz częściej w procesy CI/CD włączani są także agenci AI, którzy wspierają zespoły w diagnozowaniu i naprawianiu błędów w pipeline’ach. Potrafią przewidywać awarie, automatycznie generować testy czy wykonywać rollbacki, odciążając programistów z powtarzalnych zadań. Choć technologia ta jest jeszcze młoda i wymaga nadzoru człowieka, stanowi obiecujący kierunek rozwoju, który w przyszłości może uczynić pipeline’y jeszcze bardziej niezawodnymi i autonomicznymi.